はじめに

AWS Lambdaは2014年の登場以降、「インフラ管理からの解放」という革命をもたらしました。

サーバーのプロビジョニング、OS管理、スケーリング設計といった運用負担を意識せず、開発者はコードを書くことに集中できる世界を実現しました。

一方で、長年利用される中でいくつかの構造的な課題も見えてきました。

- 特殊なCPUアーキテクチャや高性能インスタンスが選べない

- 定常的に負荷があるワークロードではコストが割高になるケース

- コールドスタートによるレイテンシ問題

これらのギャップを埋めるために登場したのが

AWS Lambda Managed Instances(以下 LMI)です。

LMIは、Lambdaの開発体験を維持したまま、EC2の性能とコスト最適化を活用できる新しい実行モデルです。

AWS Lambda Managed Instancesとは?

AWS Lambda Managed Instances(LMI)は、EC2インスタンス上でLambdaを実行できる新しいサーバーレス実行モデルである。インフラ自体はEC2を利用するが、サーバーの管理やスケーリングはAWSが自動で行うため、ユーザーは従来のLambdaと同じ運用感覚で利用できる。

さらに、1つの実行環境で複数のリクエストを同時に処理できる仕組みにより、コスト効率とパフォーマンスの両立を実現している。サーバーレスの手軽さと、EC2の柔軟性を融合した次世代型のLambdaといえる。

決定的なメリット

① 圧倒的なコスト最適化 ― 定常ワークロードとの抜群の相性

AWS Lambda Managed Instancesの最大の価値のひとつが、EC2ベースの価格最適化モデルをそのまま活用できる点にある。

従来のLambdaはリクエスト単位・実行時間単位の従量課金だったが、LMIではインスタンス課金に切り替わり、さらに管理手数料のみが加算される構成となる。

これにより、Savings PlansやReserved Instancesを適用でき、最大72%ものコスト削減が現実的になる。

加えて、マルチコンカレンシーによって1つの実行環境を複数リクエストでフル活用できるため、アイドル時間への支払いを最小化し、定常的に負荷がかかるシステムほど高い費用対効果を発揮する。

② 特殊・高性能なコンピュートリソースを自由に活用

LMIでは、従来のLambdaでは不可能だったEC2レベルのハードウェア選択が可能になる。

最新のGraviton4プロセッサをはじめ、特定のCPUアーキテクチャやメモリ構成をワークロードに合わせて最適化できる点は、大きな進化と言える。

さらに、高帯域幅ネットワークを備えたインスタンスを選択することで、大規模データ処理やリアルタイム分析といったデータ集約型アプリケーションの性能を飛躍的に向上させることも可能だ。

なお現時点では、GPUインスタンスはLMIでは利用できず、CPUベースのコンピュートリソースに限定されている点には注意が必要である。

それでも、従来のサーバーレスが苦手としてきた高スループット・高効率処理領域をカバーできるようになったことは大きく、LMIはサーバーレスの適用範囲を本格的に拡張する転換点となっている。

③ インフラ運用ゼロのままEC2の性能を引き出す

EC2を利用する最大の課題は、運用負荷の高さだった。

パッチ適用、スケーリング設計、ロードバランサー構成、障害対応──これらはすべてエンジニアの責任だった。

しかしLMIでは、これらの運用はすべてAWSがフルマネージドで担当する。

インスタンスは自動でスケールし、セキュリティ更新も適用され、14日ごとに新しい健全な環境へローテーションされることで、常に安全性と安定性が保たれる。

つまり、EC2のパワーを使いながら、Lambdaと同じ運用体験を維持できるという革命的なモデルが実現したのである。

④ コールドスタートという長年の課題を根本から解消

従来のLambdaで避けられなかった問題が、コールドスタートによる初回遅延だった。

ミリ秒単位のレイテンシが許容できないシステムでは、これがサーバーレス採用の大きな障壁となっていた。

LMIでは、実行環境が事前にプロビジョニングされた状態で常時待機するため、リクエスト到達と同時に即時実行が可能となる。

これにより、低レイテンシが求められるAPI、金融システム、リアルタイム処理にもサーバーレスを安心して適用できるようになる。

注意すべきデメリットと制約

AWS Lambda Managed Instancesは非常に強力な実行基盤だが、万能ではない。

従来のLambdaとは異なる実行モデルである以上、事前に理解しておくべきトレードオフが存在する。

①管理手数料という新しいコスト構造

LMIでは、EC2のインスタンス料金に加えて15%の管理手数料が上乗せされる。

これは、パッチ適用、スケーリング制御、ライフサイクル管理といったフルマネージド運用に対する対価である。

オンデマンドEC2をそのまま使う場合と比較すると単価は上がるが、

一方でSavings PlansやRIを適用できる点を考慮すると、定常ワークロードでは依然として大幅なコスト最適化が可能となるケースが多い。

重要なのは、短期バースト用途よりも継続稼働型システムに向いているという特性を理解することだ。

②マルチコンカレンシーに伴うコード設計の見直し

LMI最大の構造的違いが、1つの実行環境で複数リクエストが同時処理される点である。

これは効率向上の源泉である一方、アプリケーション設計には新たな注意点をもたらす。

たとえば、

- グローバル変数の書き換え

/tmpディレクトリへのファイル書き込み- キャッシュの共有状態

これらがリクエスト間で競合を起こす可能性がある。

従来の「1リクエスト=1環境」に依存した実装は、安全性の観点から見直しが必要となり、スレッドセーフかつ完全なステートレス設計が前提条件となる。

③対応ランタイムの限定

現時点のLMIは、Node.js、Java、.NET、Pythonの最新版ランタイムに限定されている。

カスタムランタイムや古いバージョンへの対応はまだ進んでおらず、既存システムの移行においては互換性確認が必須となる。

特に、独自バイナリやレガシー環境に依存しているワークロードでは、事前検証を行わずに導入を進めるのはリスクとなる。

④リージョン提供範囲の制約

現在LMIが利用可能なリージョンは、

- 東京

- バージニア北部

- オハイオ

- オレゴン

- アイルランド

に限定されている。

グローバル展開やデータ所在地要件が厳しいシステムでは、リージョン対応ロードマップを考慮した設計判断が必要となる。

推奨ユースケース

ユースケースA:トラフィックが安定した定常ワークロード

24時間365日、継続的にリクエストが発生するAPIやバックエンド処理は、LMIと非常に相性が良い。

従来のLambdaはリクエストごとの実行時間課金モデルであるため、常時稼働型のシステムではコストが積み上がりやすい。一方LMIでは、EC2のSavings PlansやReserved Instancesを適用できるため、定常負荷があるほど単価は劇的に下がる。

実際、多くのケースで従来LambdaよりもRI適用後のLMIの方が圧倒的に安価になるという逆転現象が起こる。API基盤、認証サービス、バックエンド集約処理などは最優先で検討すべき領域だ。

ユースケースB:ハイパフォーマンス・コンピューティングや重たいバッチ処理

計算負荷が高く、CPU性能やメモリ帯域がボトルネックとなるワークロードでもLMIは強力な選択肢となる。

最新のGraviton4プロセッサをはじめとした高性能インスタンスを選択できるため、価格対性能比を大幅に向上させることが可能だ。さらに、メモリとvCPUの比率をワークロード特性に合わせて細かく調整できるため、従来のLambdaでは無駄が発生していたリソースを最適化できる。

大規模ETL処理、データ変換パイプライン、機械学習前処理など、重たい処理を効率よく回したいケースで特に効果を発揮する。

ユースケースC:コールドスタートを許容できない低レイテンシアプリケーション

ユーザー体験に直結するフロントエンド向けAPIやリアルタイム処理では、数十〜数百ミリ秒の遅延がビジネス成果に影響することも珍しくない。

LMIでは実行環境が事前にプロビジョニングされているため、従来のLambdaで問題となっていたコールドスタートが事実上排除される。これにより、常に安定したレスポンス時間を維持できる。

決済処理、検索API、モバイルアプリのバックエンドなど、レスポンスの一貫性が重要なシステムでは非常に高い価値を持つ。

導入ガイド

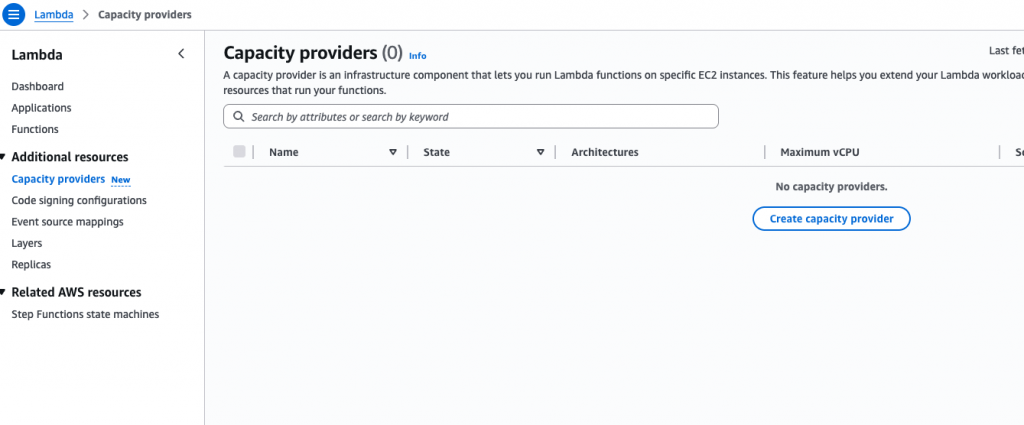

手順1:Capacity Provider(容量プロバイダー)の作成

まず、Lambdaが実行されるEC2リソース群となるCapacity Providerを作成する。

これは、どのVPC上のどのインスタンス群をLambdaの実行基盤として使うかを定義する最重要コンポーネントである。

上記画面から「Create capacity provider」を選択し、新規作成を開始する。

手順2:インスタンスタイプとスケーリングポリシーの設定

ここでは、Lambdaが実行されるEC2インスタンスが属するネットワーク環境を定義する。

通常は既存のアプリケーションVPCを指定し、Lambdaから内部サービスへ直接アクセスできる構成とするのが一般的だ。

セキュリティグループでは、必要最小限の通信のみを許可することで、Well-Architectedのセキュリティ原則に沿った設計を行う。

次に、どの種類のEC2インスタンスをLMIで使用するか、そしてどのように自動スケールさせるかを定義する。

Maximum vCPU countは、LMI全体で消費できる最大リソース量を制御する安全装置となる。

スケーリングポリシーは、CPU使用率ベースの自動調整か、固定キャパシティ型のどちらかを選択できる。

トラフィックが予測可能なシステムでは固定型、変動が大きいシステムではオートスケーリング型が推奨される。

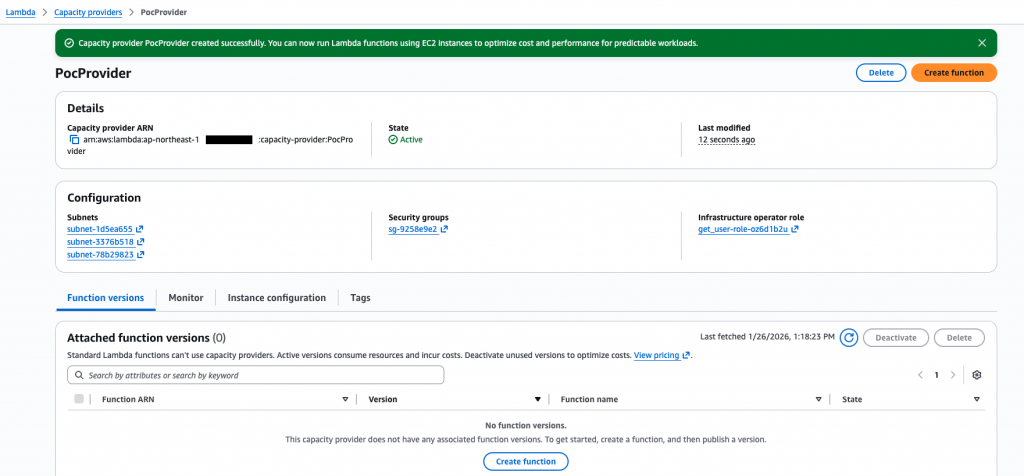

最終的に作成できたら以下のようになる。

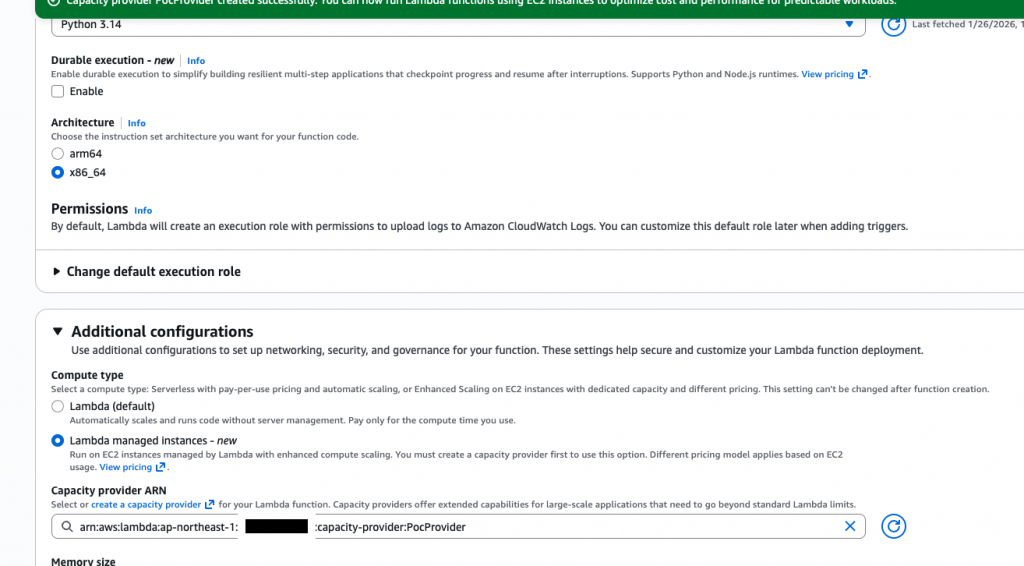

手順3:Lambda関数との紐付け設定

最後に、作成したCapacity Providerを実際のLambda関数に割り当てる。

料金モデルのシミュレーション

Lambda マネージドインスタンスの料金には 3 つの要素があります。

1.リクエスト料金: 0.20 USD/100 万リクエスト

2.コンピューティング管理料金: Lambda がプロビジョニングおよび管理するインスタンスの EC2 オンデマンドインスタンス価格の 15% 割増額 (以下に説明する各インスタンスタイプのプレミアム)

3.EC2 インスタンス料金: キャパシティプロバイダーでプロビジョニングされたインスタンスには、標準の EC2 インスタンス料金が適用されます。Compute Savings Plans、リザーブドインスタンス、またはその他の EC2 料金オプションを使用することでコストを削減できます

AWS Lambda Managed Instancesは、これまでトレードオフとして扱われてきた

**「運用のシンプルさ」と「インフラの性能・経済性」**を同時に成立させる、新しいサーバーレス実行モデルである。

フルマネージドの運用体験を維持したまま、

- EC2のコスト最適化(Savings Plans・RI)

- 高性能ハードウェアの活用

- コールドスタートの排除

- リソース集約による効率向上

を実現できる点は、従来のLambda設計の常識を大きく塗り替えるものだ。

一方で、LMIはすべてのLambdaを置き換える万能解ではない。

トラフィック特性、パフォーマンス要件、コードのステートレス性といった条件を見極めたうえで、従来型LambdaとLMIを適材適所で使い分けることが最適解となる。

これからのAWSアーキテクチャ設計において重要なのは、

「サーバーレスかEC2か」という二択ではなく、

“どのワークロードに、どの実行モデルが最も合理的か”を選択できる設計力である。

Lambda Managed Instancesは、その選択肢を一段引き上げる、次世代サーバーレスの中核となる存在になるだろう。

本記事で紹介しているAWS Lambda Managed Instances(LMI)の料金モデルおよびコスト試算は、執筆時点の東京リージョン(ap-northeast-1)における情報を前提としています。

AWSの料金、対応リージョン、サービス仕様は予告なく変更される可能性があり、

実際の請求額や利用条件はアカウント設定・利用状況・割引プラン(Savings Plans、Reserved Instances等)によって大きく異なります。

そのため、本記事の内容はあくまで設計検討の参考情報として活用し、

最新かつ正確な情報については必ずAWS公式ドキュメントおよび料金ページをご確認ください。